Qwen&清华团队颠覆常识:大模型强化学习仅用20%关键token,比用全部token训练还好

近期 arxiv 最热门论文,wen& 清华 LeapLab 团队最新成果:

在强化学习训练大模型推理能力时,仅仅 20% 的高熵 token 就能撑起整个训练效果,甚至比用全部 token 训练还要好。

团队用这个发现在 Qwen3-32B 上创造了新的 SOTA 记录:AIME ’ 24 上达到 63.5 分,AIME ’ 25 上达到 56.7 分,

这是 600B 参数以下直接从 base 模型训练的最高分。

最大响应长度从 20k 延长到 29k,AIME ’ 24 的分数更是飙升到了 68.1 分。

经典的二八法则(或帕累托法则)指出,通常 80% 的结果由 20% 的关键因素驱动,但剩下 80% 也是不能轻易舍弃的。

但是在大模型强化学习这里,80% 低熵 token 不仅可以舍弃,甚至还可能起副作用,所以这篇论文被命名为 " 超越二八法则 "。

此外,团队还从 token 熵的角度探究了 RL 对 LLM 的主要影响,并进一步讨论了 RL 与 SFT 的区别、LLM RL 的特殊性与 clip-higher 相较于 entropy bonus 的优势。

揭开 Chain-of-Thought 的熵分布密码

要理解这项研究,需要先从一个有趣的观察说起:

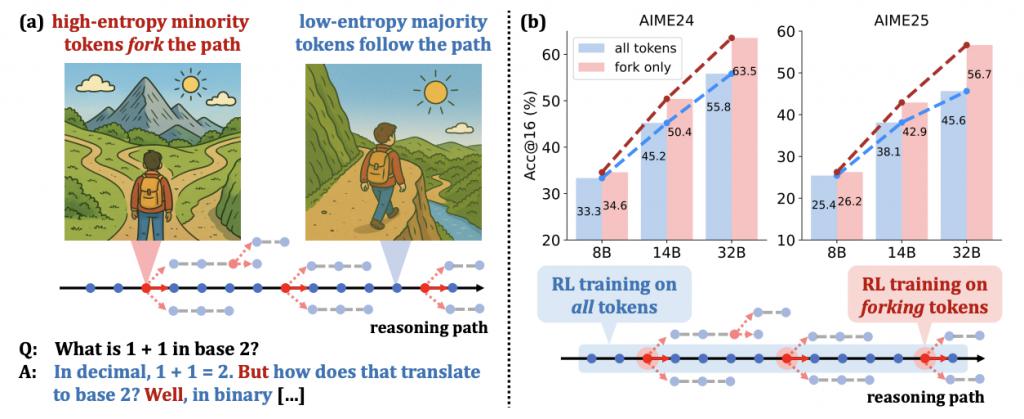

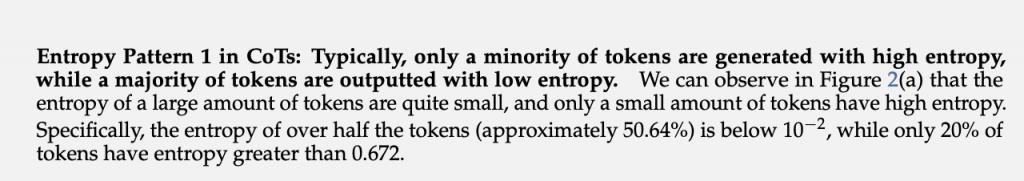

团队发现,当大模型进行链式思考(Chain-of-Thought)推理时,token 的熵分布呈现出一个独特的模式:大部分 token 的熵都很低,只有少数 token 表现出高熵特征。

具体来说,超过 50% 的 token 熵值低于 0.01,而只有 20% 的 token 熵值大于 0.672。

更有意思的是,这些高熵 token 和低熵 token 在功能上有着本质区别。高熵 token 通常扮演着 " 逻辑连接器 " 的角色,比如 "wait"、"however"、"thus" 这些词,它们在推理过程中起到转折、递进或因果连接的作用。

在数学推导中,"suppose"、"assume"、"given" 这些引入假设或条件的词也属于高熵 token。而低熵 token 则往往是词缀、代码片段或数学表达式的组成部分,这些内容具有很高的确定性。

团队形象地把这些高熵 token 称为分叉 token(forking tokens),如果将思维链比做走山路,高熵 token 就像分叉路口(fork),决定了接下来的方向;低熵 token 就像一面是山一面是悬崖的小路,只能沿着既定方向走下去。

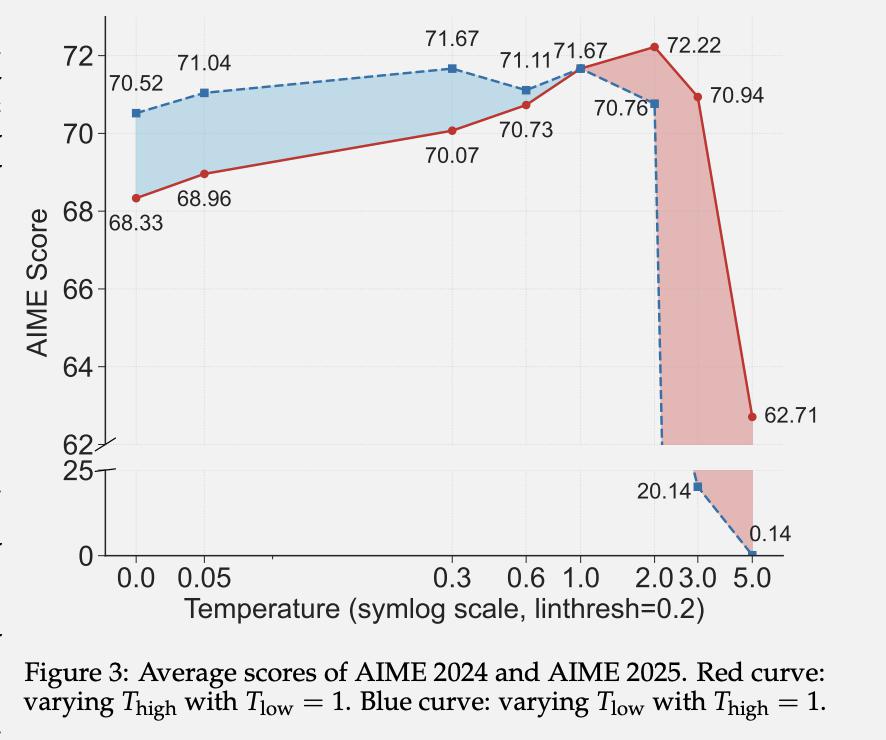

为了验证这些分叉 token 的重要性,团队还设计了这样的实验:给不同的 token 设置不同的解码温度。

结果发现,适度提高高熵 token 的温度能改善推理性能,而降低它们的温度则会导致性能下降。这进一步证实了保持这些关键位置的高熵对推理的重要性。

只用 20% 的 token,效果反而更好

既然发现了这些分叉 token 的特殊性,那么如果在强化学习训练时只关注这些关键的少数 token 会怎样?

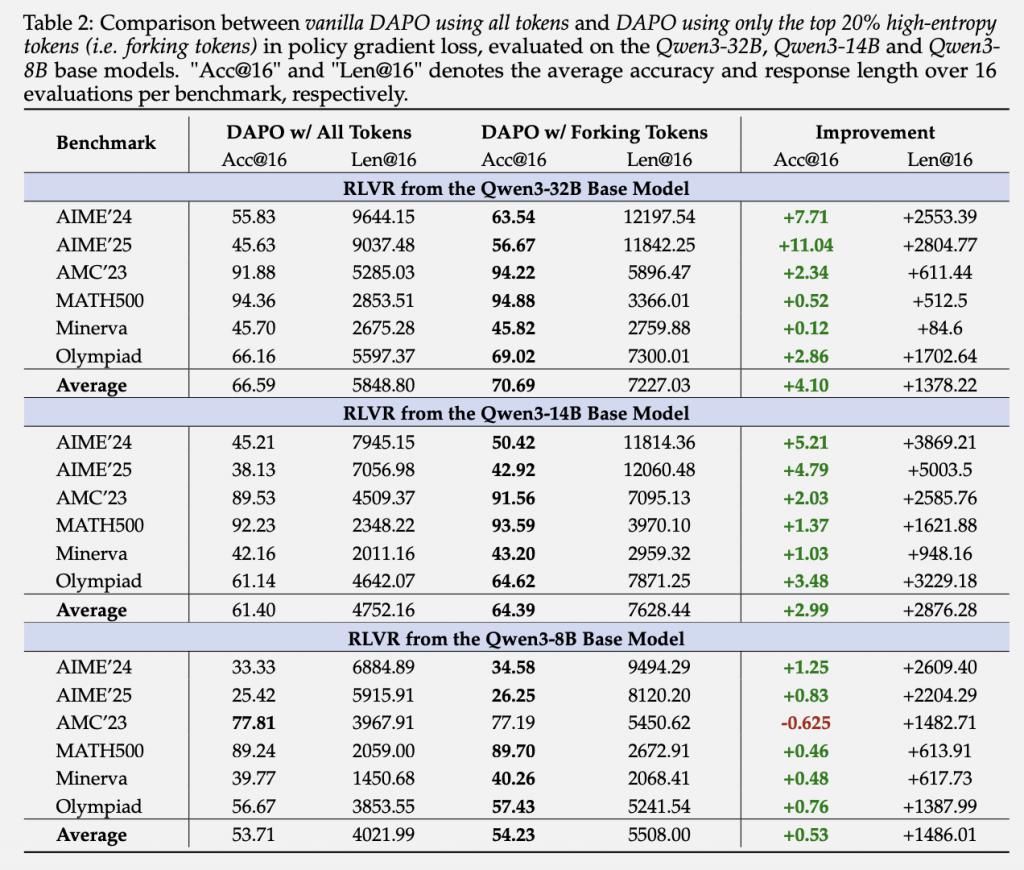

在 RLVR(Reinforcement Learning with Verifiable Rewards)训练中,只保留 top 20% 高熵 token 的策略梯度,把剩下 80% 的梯度全部屏蔽掉。

结果 Qwen3-32B 上,这种方法不仅没有降低性能,反而带来了显著提升:AIME ’ 24 分数提升 7.71 分,AIME ’ 25 分数提升 11.04 分,平均响应长度增加约 1378 个 token。

在 Qwen3-14B 上也有类似的提升效果,而在较小的 Qwen3-8B 上,性能也保持稳定。

更有趣的是反向实验的结果:如果只用 80% 的低熵 token 训练,模型性能急剧下降。

这说明低熵 token 对推理能力的提升贡献微乎其微,甚至可能起到负面作用。

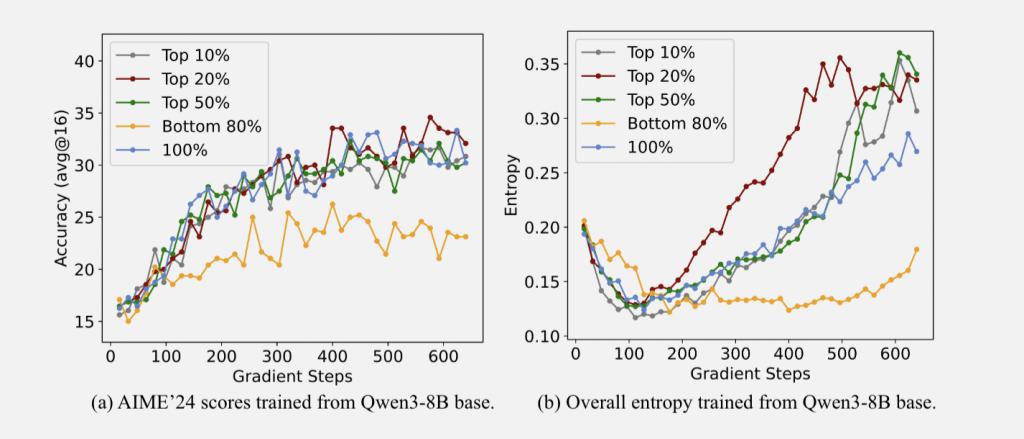

团队分析认为,这可能与路径探索有关。高熵 token 由于其不确定性,能够帮助模型探索不同的推理路径。而低熵 token 过于确定,反而限制了模型的探索能力。

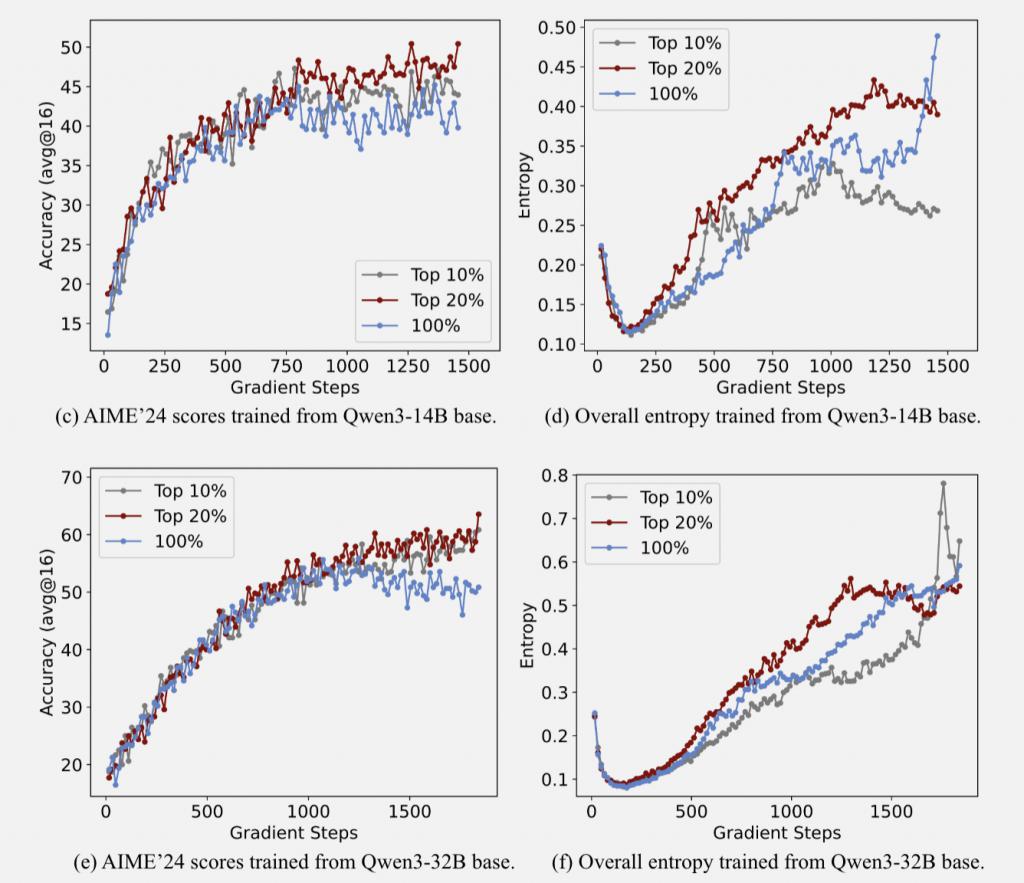

从训练过程中的整体熵变化也能看出端倪:使用 20% 高熵 token 训练时,模型保持了较高的整体熵水平,而使用全部 token 或只用低熵 token 时,整体熵水平都会下降。

另一个重要发现是这种方法存在明显的规模效应:模型越大,只用高熵 token 训练的优势就越明显。在 32B 模型上的提升最大,14B 次之,8B 模型提升最小。这可能是因为更大的模型有更强的能力利用增强的探索性。

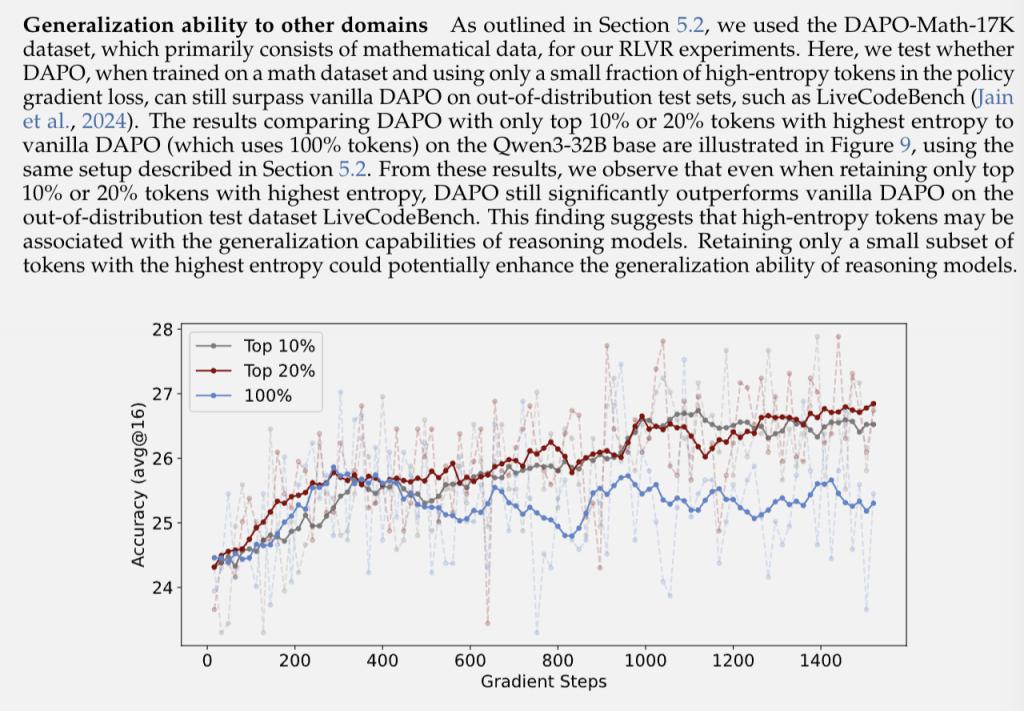

更令人惊喜的是,这种方法训练出的模型在域外任务上也表现优异。团队在数学数据集上训练的模型,在编程任务 LiveCodeBench 上测试时,仅用 20% 高熵 token 训练的模型依然大幅超越了使用全部 token 训练的版本。

这暗示着高熵 token 可能与模型的泛化能力密切相关。通过聚焦这些关键的决策点,模型学到的可能是更本质的推理模式,而不是死记硬背特定领域的知识。

重新理解大模型强化学习

这项研究的意义不止于提升训练效率,在深入研究 RLVR(Reinforcement Learning with Verifiable Rewards)训练过程后,团队发现了一个令人意外的现象:RLVR 并不是推倒重来,而是在 base model 的基础上做精细调整。

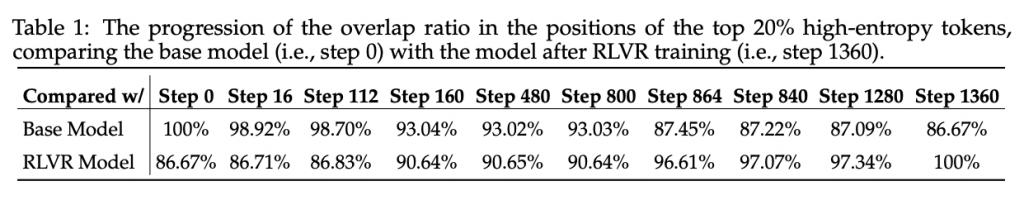

通过追踪训练过程中熵模式的演变,发现即使在训练收敛后(第 1360 步),模型与 base model 在高熵 token 位置上的重叠率仍然保持在 86.67% 以上。这意味着 RLVR 基本保留了预训练模型对 " 哪些地方该犹豫、哪些地方该确定 " 的判断。

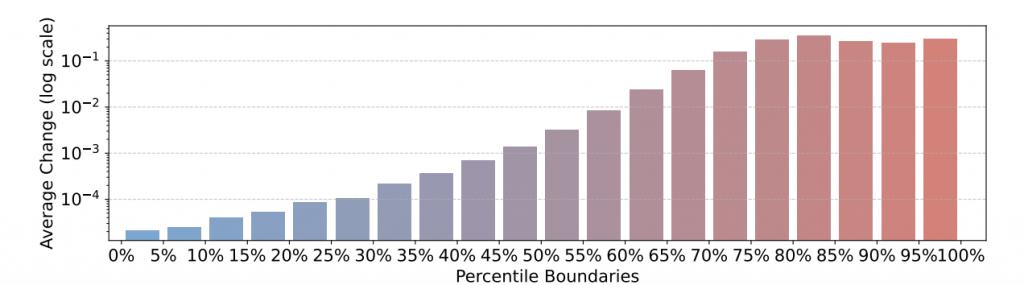

更有意思的是,RLVR 的调整策略相当 " 偏心 "。团队计算了不同熵水平 token 在训练前后的变化,发现了一个清晰的规律:

初始熵越高的 token,在 RLVR 训练后熵的增幅越大。而那些原本就很确定的低熵 token,整个训练过程中几乎纹丝不动。

从熵的百分位变化图中可以看到,越是高熵的 token(比如 90%、95% 分位),训练过程中的波动范围越大;而低熵 token(比如 0%、5% 分位)的变化微乎其微。

最后,基于以上所有这些发现,团队还提出了几个有趣的讨论:

讨论 1:高熵 token 可能是解释为什么强化学习能泛化而监督微调倾向于记忆而过拟合的关键。

强化学习倾向于保持甚至增加分叉 token 的熵,维持推理路径的灵活性。而监督微调会把输出 logits 推向 one-hot 分布,导致分叉 token 熵降低,失去了推理路径的灵活性。这种灵活性可能正是推理模型能够有效泛化到未见任务的关键因素。

讨论 2: 与传统强化学习不同,大模型推理需整合先验知识,且必须生成可读性输出。因此,大模型思维链(CoT)包含低熵的多数标记与高熵的少数标记,而传统强化学习可假设整个过程中动作熵是均匀分布的。

讨论 3:在强化学习与可验证奖励算法(RLVR)中,熵奖励(entropy bonus)可能并非最优选择,因为它会增加低熵多数标记的熵值。相比之下,clip-higher 方法能有效提升高熵少数标记的熵值。

论文

https://arxiv.org/abs/2506.01939

项目主页

https://shenzhi-wang.github.io/high-entropy-minority-tokens-rlvr/

— 完 —

量子位 AI 主题策划正在征集中!欢迎参与专题365 行 AI 落地方案,一千零一个 AI 应用,或与我们分享你在寻找的 AI 产品,或发现的AI 新动向。

也欢迎你加入量子位每日 AI 交流群,一起来畅聊 AI 吧~

一键关注 点亮星标

科技前沿进展每日见

一键三连「点赞」「转发」「小心心」

欢迎在评论区留下你的想法!